Evolution der integrierten Datenanalyse

Beispiel eines WirtschaftlichkeitsreportingsEin integriertes Datenmanagement ist für Unternehmen in der heutigen dynamischen Bauwelt von entscheidender Bedeutung. Dies gilt insbesondere für kleine und mittlere Unternehmen (KMU): Sie müssen flexibel und agil sein, um auf die ständigen Veränderungen der Umgebung proaktiv eingehen zu können. Diese Anpassungsfähigkeit ist speziell für die datengetriebene Entwicklung der Baubranche ausschlaggebend.

Datennutzung nach Bedarf und die Fähigkeit, digitale Systeme implementieren oder wechseln zu können, spielen eine zentrale Rolle. Nur wer in der Lage ist, heterogene Informationsquellen im Unternehmen und in dessen Prozessen effizient zu integrieren, schafft die Grundlage für fundierte Entscheidungen und nachhaltigen Erfolg.

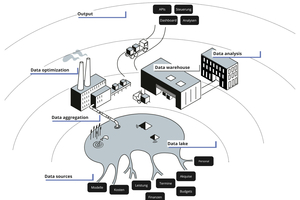

Data Lake als Basis

Ein „Data Lake“ stellt eine zentralisierte Datenumgebung dar. Er ist für das Unternehmens- und Projektmanagement heutzutage unerlässlich, um jederzeit Zugriff auf aktuelle und konsistente Informationen haben zu können. Ist er einmal angelegt, werden datenbasierte Vorhersagen und die Unterstützung der Entscheidungsfindung ermöglicht. Dabei dient der Data Lake als Daten-Hub für die Verbindung verschiedenster interner und externer Datenquellen und eröffnet eine umfassende Analyse dieser Daten.

Beim Aufbau eines Data Lakes für den Generalplaner Carpus+Partner AG ist die Formitas AG anhand der folgenden drei Kernkomponenten vorgegangen:

Datenprozesse steuern: Zunächst werden eine Infrastruktur oder Services entwickelt, die die Datenprozesse steuern. Man spricht hier von Extract-Transform-Load-Prozessen oder ETL–Pipelines. Diese ETL-Pipelines sorgen dafür, dass Daten automatisch abgefragt, aufbereitet und bereitgestellt werden können. Konkret kommt bei Carpus+Partner hier Amazon Web Services (AWS) „Glue“ zum Einsatz. Mithilfe dieses Dienstes werden bspw. Daten aus dem CRM-System und dem ERP-System in den Data Lake synchronisiert.

Datenspeicher skalieren: Das Herzstück des Data Lakes ist ein auf zukünftige Datenmengen skalierbarer Datenspeicher. Hier definiert der von AWS etablierte „Simple Storage Service”, bzw. S3, den Industriestandard. Es gibt inzwischen auch von deutschen Hostern etablierte S3-kompatible Speichersysteme. Dieser Speicher dient dazu, die Daten sammeln zu können – sowohl in Rohform als auch in aufbereiteter Form. Beim Generalplaner wird der S3-Dienst von AWS genutzt.

Daten aufbereiten: Als dritte Komponente wird ein Dienst benötigt, welcher bereits aufbereitete Daten für analytische oder darstellende Systeme abrufbar macht. Dies kann entweder ein Datenbankdienst sein, welcher performant Daten bereitstellt, oder (je nach Architektur und Anforderung des Gesamtsystems) eine verteilte SQL-Abfrage-Engine (bspw. „Trino“ oder AWS „Athena“). Diese Abfrage-Engines sind in der Lage, die im skalierbaren Datenspeicher liegenden Daten abzufragen und für externe Dienste bereitzustellen, ohne eine kostenaufwändige relationale Datenbankinfrastruktur betreiben zu müssen. Im konkreten Anwendungsfall wurde AWS „Athena“ eingesetzt.

Daten nutzbar machen

Mithilfe dieser Komponenten ist es möglich, die Daten nicht nur zusammenzuführen, sondern auch qualitativ aufzubereiten, um sie nutzbar zu machen. Denn nicht alle Daten haben in ihrer Rohform (aus der Eingabe) eine Qualität, die für Analysen geeignet ist. Mit dieser Methode werden u. a. Daten vorbereitet, deren Anwendungsfall womöglich heute noch nicht klar ist und sich erst in Kombination mit zukünftigen Daten herauskristallisiert.

Reports ableiten

Aus dieser aufbereiteten Datengrundlage kann das Unternehmen dann die Daten für ein (teil-)automatisiertes Berichtswesen bereitstellen. Dieses wird durch konsolidierte Datenflüsse – unabhängig von der Quelle – angereichert und schafft so eine stabile Grundlage für nachhaltige Unternehmensführung.

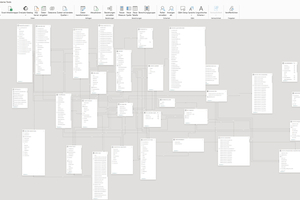

Semantisches Datenmodell

Die Visualisierung von Daten durch Tools wie „MS PowerBI“ oder Apache „Superset“ verbessert das wirtschaftliche Reporting, indem Projektberichte aus verschiedenen Quellen zeitnah kombiniert werden. Dieser kombinatorische Ansatz ermöglicht eine umfassendere Analyse unter Nutzung von Business Intelligence (BI), BIM und anderen Datenkategorien. Die Daten werden also aus dem Data Lake direkt in einen entsprechenden Service geladen und müssen jetzt noch gemäß ihrer Zusammenhänge modelliert werden. Das Modellierungsergebnis bildet die Beziehungen zwischen den einzelnen Daten ab – man spricht hier auch vom semantischen Datenmodell. Wird dieses zentral gepflegt, kann es die Grundlage für eine Vielzahl von Berichten darstellen.

Zielgruppenspezifische Datendashboards

Auf Basis des semantischen Datenmodells können nun Dashboards und Berichte erstellt werden. Das Ergebnis ist ein dynamisches Berichtssystem, das durch schnelle Aktualisierungen die Datenpflege fördert und Live-Daten mit statischen Zielen kombiniert. So erhält das Unternehmen ein genaueres Abbild der Geschäfts- und Projektlage. Konkret müssen dazu zunächst die Zielgruppen für ein entsprechendes Berichtswesen festgelegt werden. Im Anschluss kann gemeinsam mit diesen Stakeholdern ein Dashboard erstellt werden, welches das zugrunde liegende Datenmodell visuell aufarbeitet.

Kombination von Finanz-, Projekt- und BIM-Daten

Keiner der benötigten Dienste erfordert die Bereitstellung einer unternehmenseigenen Infrastruktur. Es empfiehlt sich sogar, auf externes Hosting von Diensten zu setzen, um eine schnelle Skalierung und Anpassbarkeit in beide Richtungen gewährleisten zu können. Da die Kosten von der Nutzungshäufigkeit abhängen, ist es möglich, mit verhältnismäßig geringem Aufwand zu starten. Der Aufbau der Umgebung und deren Betrieb erfordern zunächst professionelle Unterstützung, die selten im Unternehmen anzutreffen ist – jedenfalls zeigt dies die Erfahrung der Formitas AG mit diesem Themenkomplex. Ist das System jedoch einmal implementiert, kann die Nutzung der Daten (häufig in visueller Form) einer breiten Nutzerschaft im Unternehmen zur Verfügung gestellt werden.

Nach der Erfahrung der Formitas AG und ihrer Kunden stellt dieses zukunftsweisende Feld der Datennutzung die neue Basis für datengetriebenes Bauen dar: Detaillierte Kostenschätzungen, die Integration von 5D-BIM für präzise Budgetkontrollen sowie 4D-BIM zur optimierten Terminplanung ermöglichen es, Umsatzrenditen und Kosteneffizienzen transparent zu überwachen und zu steuern.

Die geschaffene Datenumgebung bildet zudem die Grundlage für den Einsatz von Künstlicher Intelligenz (KI). KI-Modelle, welche Daten analysieren und prädiktive Erkenntnisse liefern, können so auf Basis der eigenen Daten trainiert und sicher im internen System betrieben werden.